Já faz cem anos que Planck teve de lançar mão de uma expressão inusitada para explicar os seus resultados da medida da intensidade da radiação emitida por um radiador ideal - o corpo negro - levando-o assim a estabelecer o valor de uma nova constante universal que ficou conhecida como a constante de Planck. A partir daí, e também em função de outras experiências que apresentavam resultados igualmente surpreendentes no contexto da mecânica de Newton e do eletromagnetismo de Maxwell, os pesquisadores do começo do século passado se viram obrigados a formular hipóteses revolucionárias que culminaram com a elaboração de uma nova física capaz de descrever os estranhos fenômenos que ocorriam na escala atômica; a mecânica quântica.

Esta teoria, com a sua nova conceituação sobre a matéria e os seus intrigantes postulados, gerou debates não só no âmbito das ciências exatas mas também no da filosofia, provocando assim uma grande revolução intelectual no século XX. Obviamente que, além das discussões sérias e conceitualmente sólidas, as características não cotidianas dos fenômenos quânticos levaram muitos pesquisadores, e também leigos, a formular interpretações equivocadas da nova teoria, o que infelizmente, ainda nos nossos dias, atrai a atenção das pessoas menos informadas.

Mas, no final das contas, quais são estes efeitos tão estranhos dos quais estamos falando e qual é a sua relevância para o nosso cotidiano, se existe alguma? Bem, para provar que não estamos falando de coisas inúteis, comecemos pela segunda parte desta pergunta.

O leitor certamente se surpreenderia se disséssemos que sem a mecânica quântica não conheceríamos inúmeros objetos com os quais lidamos corriqueiramante hoje em dia. Só para se ter uma idéia podemos mencionar o nosso aparelho de CD, o controle remoto de nossas TVs, os aparelhos de ressonância magnética em hospitais ou até mesmo o micro-computador que ora usamos na elaboração deste artigo. Todos os dispositivos eletrônicos usados nos equipamentos da chamada high-tech só puderam ser projetados porque conhecemos a mecânica quântica. A título de informação, 30% do PIB americano é devido a estas tecnologias.

Esperando ter convencido o leitor de que estamos longe do terreno da especulação, vamos, então, abordar a primeira parte da pergunta acima lançada. O que é a mecânica quântica?

A mecânica quântica é a teoria que descreve o comportamento da matéria na escala do "muito pequeno", ou seja, é a física dos componentes da matéria; átomos, moléculas e núcleos, que por sua vez são compostos pelas partículas elementares. Muito interessante mas…o que isto nos traz de novo?

A fim de podermos apreciar as novidades que a física quântica pode nos proporcionar, vamos estabelecer alguns conceitos clássicos que nos serão muito úteis adiante.

O primeiro conceito é o de partícula. Para nós este termo significa um objeto que possui massa e é extremamente pequeno, como uma minúscula bolinha de gude. Podemos imaginar que os corpos grandes sejam compostos de um número imenso destas partículas. Este é um conceito com o qual estamos bem acostumados porque lidamos diariamente com objetos dotados de massa e que ocupam uma certa região do espaço.

O segundo conceito é o de onda. Este, apesar de ser também observado no nosso dia a dia, escapa à atenção de muitos de nós. Um exemplo bem simples do movimento ondulatório é o das oscilações da superfície da água de uma piscina. Se mexermos sistematicamente a nossa mão sobre esta superfície, observaremos uma ondulação se afastando, igualmente em todas as direções, do ponto onde a superfície foi perturbada.

O caso particular aqui mencionado é o de onda material, ou seja, aquela que precisa de um meio material para se propagar (a água da piscina no nosso caso). Entretanto, esse não é o caso geral. Há ondas que não precisam de meios materiais para a sua propagação, como é o caso da radiação eletromagnética. Aqui, a energia emitida por cargas elétricas aceleradas se propaga no espaço vazio (o vácuo) como as ondas na superfície da piscina.

Apesar da sua origem mais sutil, a radiação eletromagnética está também presente na nossa experiência diária. Dependendo da sua frequência ela é conhecida como: onda de rádio, FM, radiação infravermelha, luz visível, raios-X e muito mais.

Pois bem, até o final do século XIX tudo o que era partícula tinha o seu movimento descrito pela mecânica newtoniana enquanto que a radiação eletromagnética era descrita pelas equações de Maxwell do eletromagnetismo.

O que ocorreu no primeiro quarto do século XX foi que um determinado conjunto de experiências apresentou resultados conflitantes com essa distinção entre os comportamentos de onda e de partícula. Estes resultados podem ser resumidos em uma única experiência que passamos a descrever, em seguida, na sua versão clássica.

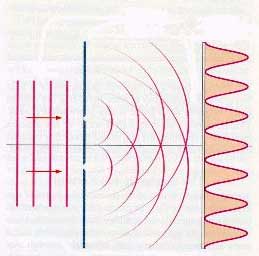

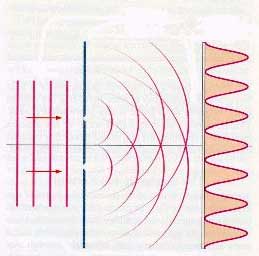

Imagine que uma onda, material ou não, incida sobre um anteparo opaco onde haja duas fendas (ver figura abaixo). Cada uma das fendas passa então a ser fonte de um novo movimento ondulatório. Uma característica fundamental deste movimento é o fenômeno de interferência, que reflete o fato das oscilações provenientes de cada uma das fendas poderem ser somadas ou subtraídas uma da outra. Colocando-se agora um segundo anteparo, distante do primeiro, onde iremos detetar a intensidade da onda que o atinge, observaremos como resultado uma figura que alterna franjas com máximos e mínimos da intensidade da onda. Esta é a chamada figura de interferência.

|  |

a) arranjo experimental | b) visão frontal do segundo anteparo |

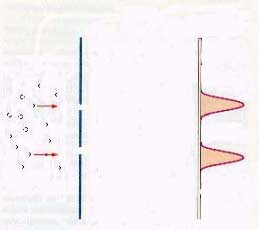

Vamos agora repetir a mesma experiência com a diferença que, ao invés de ondas, incidimos partículas sobre o primeiro anteparo. O que ocorre nesta nova situação é a presença de duas concentrações distintas de partículas atingindo o segundo anteparo. Aquelas que passam por uma ou outra fenda, como mostra a figura abaixo.

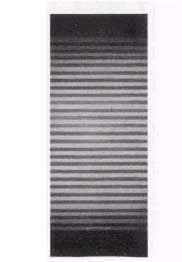

Este seria, portanto, o resultado esperado pela física clássica. Entretanto, quando esta experiência é feita com partículas como elétrons ou nêutrons, ocorre o inesperado: forma-se no segundo anteparo uma figura de interferência na concentração de partículas que a atingem, como mostramos em seguida.

Ainda mais estranho é a repetição desta mesma experiência com apenas uma partícula. Ela passa pelo primeiro anteparo e atinge o segundo em apenas um ponto. Vamos, então, repetir esta mesma experiência um número enorme de vezes. O resultado é que em cada experimento o ponto de deteção no segundo anteparo é diferente. Entretanto, sobrepondo todos os resultados obtidos nos segundos anteparos de cada experiência obtém-se, novamente, a mesma figura de interferência da figura anterior!

Assim, mesmo falando de apenas uma partícula, nos vemos obrigados a associá-la a uma onda para que possamos dar conta da característica ondulatória presente no nosso exemplo. Por outro lado, devemos relacionar esta onda à probabilidade de se encontrar a partícula em um determinado ponto do espaço para podermos entender os resultados de uma única experiência de apenas uma partícula. Este é o chamado princípio da dualidade onda-partícula.

Um outro fato intrigante ocorre quando tentamos determinar por que fenda a partícula passou. Para resolver esta questão podemos proceder fechando uma das fendas para ter certeza que ela passou pela outra fenda. Outra surpresa: a figura de interferência é destruida dando lugar a apenas uma concentração bem localizada de partículas, a daquelas que passaram pela fenda aberta! Portanto, ao montarmos um experimento que evidencia o carater corpuscular da matéria, destruimos completamente o seu carater ondulatório, ou seja, o oposto ao caso com as duas fendas abertas. Este é o princípio da complementaridade.

De uma forma geral podemos interpretar os resultados do experimento aqui descrito como os de um sistema sujeito a uma montagem na qual o seu comportamento depende de alternativas A e B (no nosso caso, a passagem da partícula por uma das fendas). Enquanto que na mecânica clássica o sistema escolhe A ou B, aleatoriamente, na mecânica quântica estas duas alternativas interferem. Entretanto, ao questionarmos, ou melhor, medirmos, por qual alternativa o sistema opta, obteremos o resultado clássico.

Um sistema quântico, ao contrário do clássico, só pode ser descrito através das possíveis alternativas (não necessariamente apenas duas) que a nossa montagem apresente para ele. A onda associada ao sistema carrega a possibilidade de interferência entre as diferentes alternativas e é a informação máxima que podemos ter sobre o sistema em questão.

A aplicação desta teoria a problemas nas escalas atômicas e sub-atômicas apresenta resultados como a quantização da energia ou o tunelamento quântico que, por si só, já mereceriam a elaboração de um outro artigo para que o leitor pudesse apreciá-los.

O mais interessante é que a mecânica quântica descreve, com sucesso, o comportamento da matéria desde altíssimas energias (física das partículas elementares) até a escala de energia das reações químicas ou, ainda de sistemas biológicos. O comportamento termodinâmico dos corpos macroscópicos, em determinadas condições, requer também o uso da mecânica quântica.

A questão que nos resta é então; por quê não observamos estes fenômenos no nosso cotidiano, ou seja, com objetos macroscópicos? Bem, há duas razões para isso. A primeira é que a constante de Planck é extremamente pequena comparada com as grandezas macroscópicas que têm a sua mesma dimensão. Baseados neste fato, podemos inferir que os efeitos devidos ao seu valor não nulo, ficarão cada vez mais imperceptíveis à medida que aumentamos o tamanho dos sistemas. Em segundo lugar, há o chamado efeito de descoerência. Este efeito só recentemente começou a ser estudado e trata do fato de não podermos separar um corpo macroscópico do meio onde ele se encontra. Assim, o meio terá uma influência decisiva na dinâmica do sistema fazendo com que as condições necessárias para a manutenção dos efeitos quânticos desapareçam em uma escala de tempo extremamente curta.

Entretanto, as novas tecnologias de manipulação dos sistemas físicos nas escalas micro ou até mesmo nanoscópicas nos permitem fabricar dispositivos que apresentam efeitos quânticos envolvendo, coletivamente, um enorme número de partículas. Nestes sistemas a descoerência, apesar de ainda existir, tem a sua influência um pouco reduzida, o que nos permite observar os efeitos quânticos durante algum tempo.

Uma aplicação importante para alguns destes dispositivos seria a construção de processadores quânticos, o que tornaria os nossos computadores ainda mais rápidos. Nesta situação a minimização dos efeitos da descoerência é altamente desejável pois, em caso contrário, estes processadores de nada iriam diferir dos processadores clássicos.

Como podemos ver, tudo indica que a mecânica quântica seja a teoria correta para descrever os fenômenos físicos em qualquer escala de energia. O universo macroscópico só seria um caso particular para o qual há uma forma mais eficiente de descrição; a mecânica newtoniana. Esta pode ser obtida como um caso particular da mecânica quântica mas a recíproca não é verdadeira.

Muitos autores, por não se sentirem confortáveis com a chamada interpretação ortodoxa ou de Copenhagen da mecânica quântica, tentam criar teorias alternativas para substituí-la. Entretanto, cabe notar que, apesar da sua estranheza, a mecânica quântica não apresentou qualquer falha desde que foi elaborada na década de 20, o que não nos proporciona evidência experimental que aponte para onde buscar as questões capazes de derrubá-la.

link original

Condutores elásticos oferecem avanços para "wearable computers" (Fonte da imagem: ntech.t.u-tokyo.ac.jp)

Condutores elásticos oferecem avanços para "wearable computers" (Fonte da imagem: ntech.t.u-tokyo.ac.jp)